Soubor robots.txt patří mezi klíčové nástroje optimalizace webu. Jde sice „jen“ o textový soubor s několika příkazy, ale právě díky němu dokáže SEO specialista specifikovat, ke kterému obsahu se roboti vyhledávačů dostanou. Správně optimalizovaný soubor robots.txt tak hraje zásadní roli v tom, zda na Google či jiném vyhledávači bude obsah našeho webu vidět. V době velkých jazykových modelů přitom může být jeho role ještě mnohem důležitější.

Díky LLM je totiž v internetovém prostředí opět více botů s různými úkoly, jejichž chování můžeme pomocí robots.txt ovlivnit. A v mnoha případech se to může vyplatit. Nejprve se však zaměřme, co to vlastně robots.txt je, k čemu slouží a jaký je jeho doporučený zápis.

Co je robots.txt a k čemu slouží?

Soubor robots.txt slouží k tomu, aby sdělil botům vyhledávačů (např. Googlebot, SeznamBot, Bingbot, ale dnes i GPTBot či PerplexityBot), které části webu mohou procházet (a potažmo následně indexovat) ,a které nikoli. Jde o jednoduchý textový soubor, který je uložen v kořenovém adresáři vašeho webu, např. „www.digichef.cz/robots.txt“.

Robots.txt má několik účelů:

- Ochrana interních dat: Můžete jím omezit procházení citlivých sekcí, např. administrace webu nebo uživatelských účtů.

- Zefektivnění indexace: Když bot nebude zbytečně procházet stránky bez hodnotného obsahu, vyhledávače se mohou více soustředit na důležitou část webu, což se hodí hlavně u velkých webů.

- SEO výhody: Efektivní konfigurace robots.txt zrychluje procházení webu a zrychluje se tak indexace nového obsahu.

Základní syntaxe a pravidla robots.txt

Soubor robots.txt využívá několik direktiv, které je dobré znát:

User-agent

Tato direktiva definuje, pro kterého robota platí následující pravidla. Lze přitom specifikovat různá pravidla pro různé boty.

- „User-agent: *“ znamená, že stanovená pravidla se vztahují na všechny roboty.

- „User-agent: Googlebot“ omezuje pravidla pouze na Googlebot.

Disallow a Allow

- „Disallow“ označuje sekci (cestu či konkrétní URL), kam robot nesmí.

- „Allow“ naopak výslovně povoluje procházení určité sekce.

Sitemap

Přímo do souboru robots.txt je vhodné vložit také odkaz na soubor sitemap.xml. Tím usnadníte vyhledávačům nalezení všech důležitých stránek.

Pravidla pro boty AI nástrojů

Pravidla pro zakázání procházení jednotlivým user-agentům přitom do budoucna mohou být ještě důležitější než dosud. Už v minulosti se objevovaly soubory robots.txt specificky zakazující procházení webu např. AhrefsBotem. Webmasteři se tak snažili reagovat na přetěžování serveru tímto botem nebo si před ním chránili citlivá data.

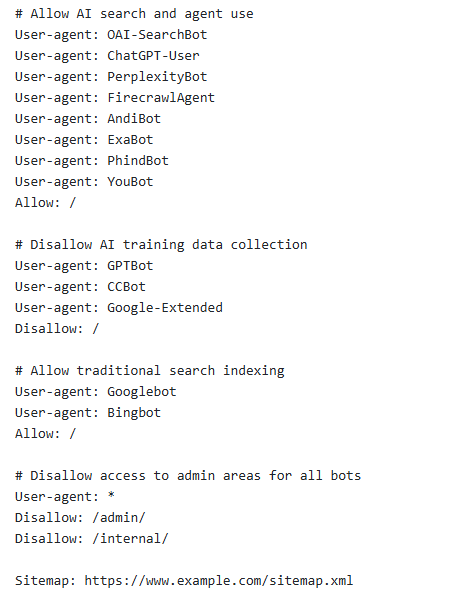

Dnes zápis takových pravidel s podobným cílem opět roste, tentokrát jsou nicméně zaměřena právě na user-agenty botů AI nástrojů. Díky tomu se už objevují různá doporučení, jak v době AI robots.txt upravit. Na SearchEngineLand.com se objevilo doporučení např. na následující zápis:

Tip na zápis robots.txt v době AI

Tímto zápisem umožníte přístup botů velkých jazykových modelů na svůj web, ale zároveň zakážete trénování dat těmito nástroji na vašem obsahu. Není divu, že takový zápis už začaly používat některé velké zpravodajské servery (v ČR např. aktualne.cz).

User-agenti nejdůležitějších AI nástrojů

OpenAI

- GPTBot (pro trénování na datech)

- ChatGPT-User (akce uživatelů v ChatGPT)

- OAI-SearchBot (výsledky vyhledávání v SearchGPT)

- Google-Extended (trénování AI)

- GoogleOther (různá využití AI)

Anthropic

- ClaudeBot (různá využití AI)

Perplexity

- PerplexityBot

Common Crawl

- CCBot (pro trénování dat různých společností)

Kompletní seznam botů AI nástrojů, respektive jejich user-agentů najdete např. na DarkVisitors.com. Perplexity.ai pak bližší informace shrnuje na svém webu, podobné informace najdete i na webu OpenAI.

Důvody pro a proti blokování AI botů

Hlavním důvodem pro blokaci AI nástrojů je snaha chránit autorská práva nebo citlivá data. Zpravodajské servery blokováním obsahu chrání jeho monetizaci, možná i se snahou vyjednat si lepší podmínky s OpenAI a dalšími provozovateli LLM o poskytnutí svého obsahu.

Na druhou stranu blokování obsahu může být i rizikové, hlavně z hlediska povědomí o brandu. Návštěvnost AI toolů dále poroste, a pokud se uživatelé o vašem brandu v nich nedočtou, může váš brand vejít k zapomnění.

Navíc pokud se váš obsah nedostane do tréninkových datasetů, mohou AI modely hůře odpovídat na otázky týkající se vaší značky či tématu, což opět může mít za následek sníženou „viditelnost“ brandu. Je proto se nutné vždy dobře zamyslet nad tím, zda se nám blokace botů vyplatí a zda má v našem případě smysl.

Jak upravovat robots.txt v době AI?

Z toho všeho je jasné, že neexistuje jednotná odpověď, jak optimalizovat robots.txt v době AI. Opět záleží na účelu webu nebo taktice jeho provozovatele. Hlavně zpravodajské servery nicméně mohou mít dobré důvody, proč trénování dat na svém obsahu blokovat. Každopádně je nejvyšší čas si otázku, zda chceme být v LLM vidět, položit a vědět, co pro to udělat.

SEO

SEO 6. 3. 2025

6. 3. 2025